1.

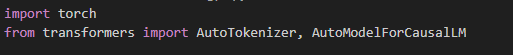

model_name = "Qwen/Qwen2.5-Coder-32B-Instruct"

model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype="auto",

device_map="auto"

)

tokenizer = AutoTokenizer.from_pretrained(model_name)

위와 같이 Qwen 모델을 local 환경에서 돌리려고 했다.

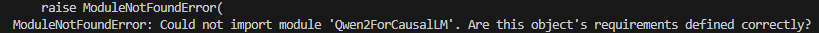

raise ModuleNotFoundError(

ModuleNotFoundError: Could not import module 'Qwen2ForCausalLM'. Are this object's requirements defined correctly?

하지만 ModuleNotFoundError 로 Qwen2ForCausalLM이 import가 안된다는 에러가 떴다.

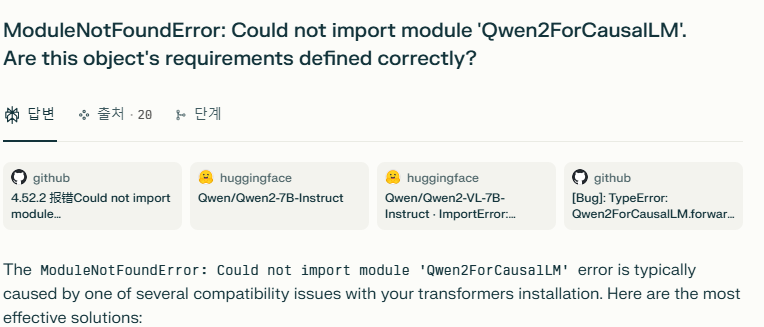

모듈을 못 찾는 에러는, 보통 패키지 버전 문제

해당 모듈 AutoModelForCausalLM은 transformers 패키지에서 import 즉 가져오고 있으므로

transformers 패키지를 제대로 설정하는 것이 필요했다

해결 - pip install transformers==4.39.1

원래 transformers가 4.55.x 로 굉장히 최신 버전이었다

pip upgrade를 해도 해결되지 않아서, qwen coder github requirement에서 추천하는

4.39.1 버전을 설치해보기로 했다

GitHub - Universal-Invariant/AI-QWEN-Coder: Qwen2.5-Coder is the code version of Qwen2.5, the large language model series develo

Qwen2.5-Coder is the code version of Qwen2.5, the large language model series developed by Qwen team, Alibaba Cloud. - Universal-Invariant/AI-QWEN-Coder

github.com

vllm 이라는 패키지 설치하면

이렇게 추가 118 여 개의 패키지가 추가로 설치된다

그러면 다시 transformers가 4.55.0 으로 upgrade되니까 주의

pip install transformers==4.39.1

pip install transformers==4.39.1

위 코드를 실행하여 제대로 된 transformers 패키지를 설치해주었다.

transformer 버전을 맞추니까 safetensor 및 모델이 다운로드 되기 시작했다!

Reference

Claude는 무조건 upgrade하는 방법을 추천해줬는데,

downgrade가 해결법이었다.